엄청난 양의 독서 (학습)

AI는 태어나자마자 똑똑한 것이 아닙니다. 개발자들은 AI에게 도서관 전체를 통째로 읽힙니다. 이 과정에서 AI는 단순히 글자를 외우는 것이 아니라, 단어와 단어 사이의 '관계'를 지도로 그립니다.

핵심: "사과는 빨갛다", "사과는 맛있다" 같은 패턴을 익힙니다.

심화 설명 펼치기: 단어를 숫자로 바꾸는 마법 (Embedding) ▼

컴퓨터는 '사과'라는 글자를 이해하지 못합니다. 그래서 모든 단어를 숫자 좌표(벡터)로 바꿉니다. 이것을 임베딩(Embedding)이라고 합니다.

-

비슷한 뜻을 가진 단어는 좌표 공간에서도 서로 가까운 곳에 위치합니다.

(예: '왕'과 '여왕'은 가깝고, '왕'과 '사과'는 멉니다.) - 수식 맛보기: $$ \text{Sim}(A, B) = \frac{A \cdot B}{\|A\| \|B\|} $$ 이 수식은 두 단어 A와 B가 얼마나 비슷한지 계산하는 '코사인 유사도' 공식입니다. 각도가 좁을수록(1에 가까울수록) 비슷한 단어라는 뜻입니다.

단어 관계도 (Word Embeddings)

단어들이 의미에 따라 뭉쳐있는 모습을 시각화

다음에 올 토큰 예측 확률

빈칸 채우기 (토큰 예측)

LLM의 핵심은 '검색'이 아니라 '예측'입니다. 하지만 AI는 우리가 쓰는 '단어'가 아닌 '토큰(Token)'이라는 조각 단위로 언어를 이해합니다.

🔹 토큰이란? 텍스트를 처리하는 기본 단위입니다. 영어는 약 0.75단어가 1토큰, 한글은 글자나 형태소 단위로 쪼개집니다.

🔹 학습 규모: Gemini나 ChatGPT 같은 모델은 인터넷 상의 수 조(Trillions) 개의 토큰을 학습하며, 약 10만~20만 개의 고유한 토큰 사전(Vocabulary)을 가지고 있습니다.

AI는 앞의 문맥 토큰들을 보고, 확률적으로 가장 적절한 다음 토큰을 선택합니다.

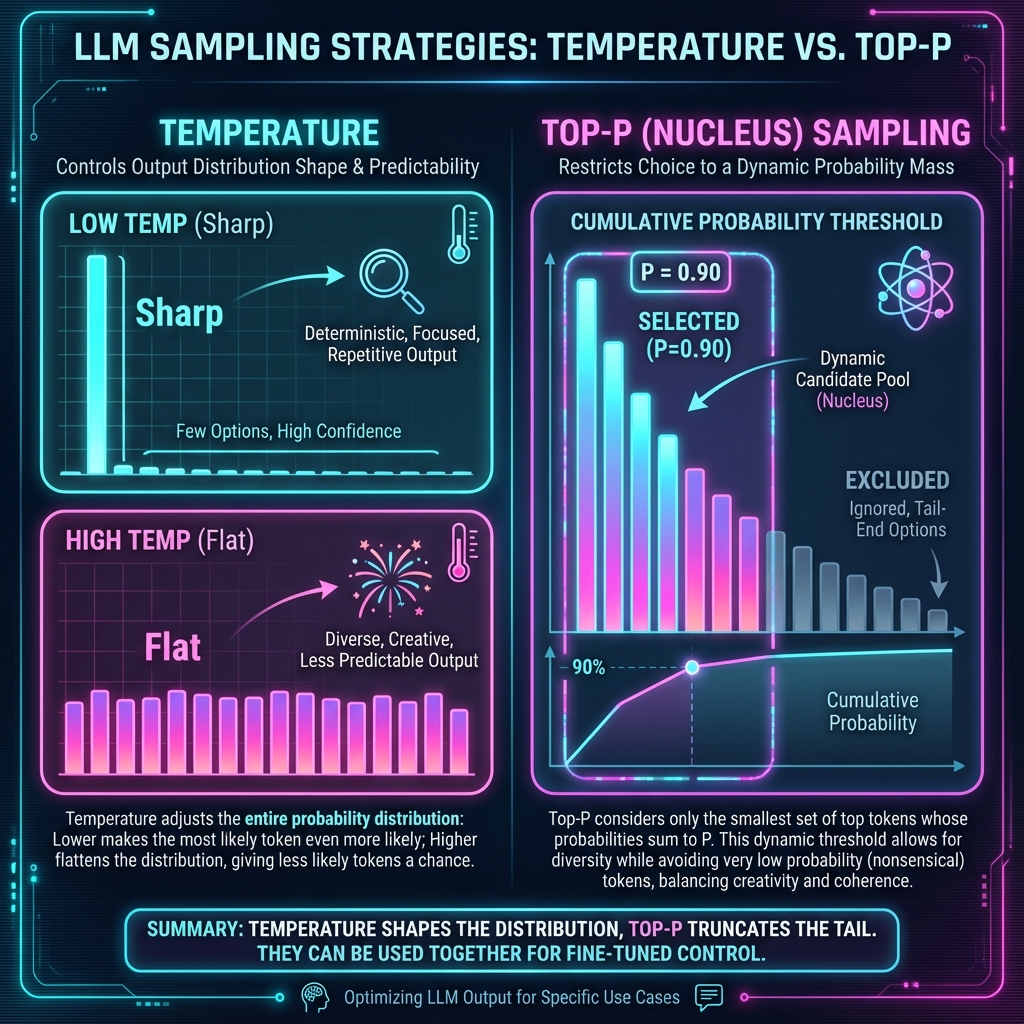

심화 설명 펼치기: AI의 창의성 조절 (Temperature, Top-p) ▼

AI가 다음 단어를 고를 때 주사위를 굴린다는 사실을 아시나요? 가장 확률이 높은 단어만 무조건 고르는 게 아니라, 가끔은 엉뚱한 단어를 골라야 창의적인 글이 나옵니다.

이때 Temperature(온도)라는 값을 조절해서 AI의 성격을 바꿀 수 있습니다.

- 온도가 낮으면 (0.1 ~ 0.3): 모범생 모드.

가장 정답에 가까운 단어만 고릅니다. (논리적인 글, 코딩에 적합) - 온도가 높으면 (0.8 ~ 1.5): 예술가 모드.

확률이 조금 낮은 단어도 과감하게 고릅니다. (시 쓰기, 아이디어 내기에 적합)

2. Top-p (Nucleus Sampling):

확률 순위가 아니라 누적 확률로 자르는 방식입니다.

예를 들어 Top-p = 0.9라면, 상위 1등부터 확률을 더해나가다가 90%가 채워지는 순간 그 뒤의 후보들은 모두 탈락시킵니다.

→ 효과: 말도 안 되는 헛소리(확률 낮은 꼬리)를 확실하게 잘라내어 안정성을 높입니다.

Temperature(분포 모양 조절) vs Top-P(꼬리 자르기) 시각화

수식 맛보기: $$ P(t) = \text{softmax}\left(\frac{\text{점수}}{\text{온도}}\right) $$ 온도(T)로 점수를 나누기 때문에, 온도가 높을수록 점수 차이가 줄어들어(평평해져) 아무거나 뽑힐 확률이 늘어납니다.

실시간 확률 분포 변화

* 슬라이더를 움직여보세요! 파란색은 선택 가능한 후보(Nucleus), 회색은 탈락한 후보입니다.

🧩 토크나이저 체험 (Tokenizer Simulator)

AI가 문장을 어떻게 조각내서 보는지 체험해보세요. (교육용 시뮬레이션으로, 실제 모델의 복잡한 토크나이저와는 다를 수 있습니다.)

OpenAI ChatGPT 가 실제 사용하는 토크나이저를 이곳에서 실제로 시도해 볼 수 있습니다.

ChatGPT 토크나이저 체험하기눈치 100단 (문맥 파악)

단어 하나만 보지 않고 문장 전체를 훑어봅니다. 이를 '어텐션(Attention)' 메커니즘이라고 합니다. 같은 단어라도 주변 상황에 따라 완전히 다르게 해석합니다.

상황 A: "나는 배가 고파서 식당에 갔다."

상황 B: "나는 배를 타고 바다로 나갔다."

심화 설명 펼치기: 집중해야 할 곳을 찾는 Attention ▼

AI가 문장을 이해하는 방식은 도서관에서 책을 찾는 것과 비슷합니다.

1. 세 가지 역할 (Q, K, V):

- Query (질문): "내가 지금 찾고 싶은 내용은 뭐야?" (검색어)

- Key (색인): "이 책은 어떤 내용을 담고 있어?" (책 제목/라벨)

- Value (내용): "그 책의 실제 내용은 뭐야?" (책 본문)

2. 작동 원리 (Attention Score):

AI는 검색어(Q)와 책 제목(K)이 얼마나 비슷한지 계산합니다. (이것을 '내적'이라고 합니다.)

비슷할수록 점수가 높아지고, 점수가 높은 책의 내용(V)을 더 많이 참고해서 문맥을 파악합니다.

수식으로 보면:

$$ \text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V $$(Q와 K를 곱해서 유사도를 구하고, 그 비율만큼 V를 섞는다)

단어 '배'에 대한 AI의 인식 변화

선생님의 지도 (미세 조정)

인터넷 글을 무작정 배우면 욕설이나 가짜 뉴스도 배웁니다. 마지막 단계에서 '사람 선생님'이 개입하여 AI를 예의 바르고 유용하게 만듭니다.

초기 모델 (Base Model)

필터링 없음, 가끔 무례함, 부정확함

조정된 모델 (Fine-Tuned)

안전함, 도움됨, 예의 바름

심화 설명 펼치기: AI를 착하게 만드는 방법 (RLHF) ▼

AI에게 "좋아요"와 "싫어요"를 가르치는 과정입니다. 마치 강아지를 훈련시키는 것과 비슷합니다.

- SFT (지도 학습): 선생님이 직접 "질문에는 이렇게 대답해"라고 모범 답안을 보여줍니다.

-

RLHF (인간 피드백 강화학습):

- AI가 여러 가지 답변을 내놓습니다.

- 사람이 더 좋은 답변에 투표합니다. (랭킹 매기기)

- AI는 투표를 많이 받은 쪽으로 행동을 수정합니다. (보상 받기)

AI 응답의 신뢰성 (예시)

말을 잘 지어내는 소설가에 가깝습니다.

주의: 할루시네이션 (환각, Hallucination)

AI는 확률적으로 단어를 조합하다 보니, 가끔 없는 사실을 마치 진짜인 것처럼 아주 뻔뻔하게 거짓말을 합니다. 이를 '할루시네이션'이라고 합니다.

작동 원리를 이해하셨다면, 이제 본격적인 실습으로 넘어갑니다.

Module 1: 오프닝 & 핵심 개념 시작하기 →